Romley@Xeon E5 英特尔“云端”利器

在接下来的万兆网络时代,它将充当普及先锋的角色;

在接下来的云计算时代,它将承担90%的服务器计算应用;

它能为你带来数倍于当前同规格服务器的计算性能,它就是新一代Romley平台,它就是英特尔至强E5系列处理器。

2012年3月7日,英特尔在北京正式发布了以新一代至强E5处理器为核心的Romley平台。作为一个为云计算而生的服务器平台,Romley带来了包括处理器、芯片组、主板设计和外围扩展在内的全方位解决方案。在英特尔的规划中,新的至强E5处理器已不再是单单满足计算性能提升而诞生的换代产品。相比上代主流至强产品X5500系列,E5更像是个云计算时代的多面手。用戴伟德(Boyd Davis)的话来说,E5带给你的是多元化的价值!

戴伟德(Boyd Davis):多元价值助至强E5挑战多元云环境

戴伟德:英特尔架构事业部副总裁及数据中心基础架构事业部总经理。

有人曾问我关于新至强E5产品的“成本回收周期”问题,这个词在我们2008~2009年发布至强X5500系列时确实提到过。但和那时不同,现在的我们更看重新至强E5的综合能力。在发布会上,我们已经传达了一个关键信息:E5面临的不是简单的计算性能挑战。当前的应用环境有着许多其他方面的制约,比如I/O的瓶颈。想解决各种挑战的话,内存、I/O、安全、功耗都需要创新。而在此之前,我们让服务器退休都主要是从计算性能的角度考虑。现在会有更多的考虑,比如能不能使用更优秀的安全技术,能不能进行能耗管理,能不能进行优化管理。这已经不只是成本回收这个简单的话题,我们的价值体系已经多元化。此外,在我们看来,为了保证IT服务的效率,服务器的四年退休周期已经到来。

其实就全球的数据中心市场来说,即使没有至强E5,其相关技术还是会发展,毕竟全球对于计算的需求量非常大。尤其是增长迅速的中国市场,对服务器的需求量要高于其他市场3倍。而新的至强E5能够满足更多应用需求,它解决了云计算时代除了计算性能外的更多瓶颈,例如I/O和安全。这无疑能促进行业的蓬勃发展,加快行业更新速度。这一“供”一“需”,让我们对2012年非常乐观。从整个市场来看,也有至少三个原因,让我们相信乐观的判断:

一、对于传统如RISC、存储和网络应用的专有架构正在向IA英特尔的架构进行转变,这给我们带来了更多参与市场的机会。

二、现在互联网服务在大幅度增长,用户和互联网互动的方式越来越多,服务器需求剧增。

三、市场对高性能计算的需求越来越多。如很多的研发工作和科学工作,以往都通过真正的实体进行试验和建模,而现在都通过计算的方式来模拟和分析。

至强E5 2600系列产品技术解析

说了这么多对Romley平台和新至强E5处理器的肯定和期望,它究竟有哪些新技术来承载这份期望呢?让我们先从处理器的特性说起。

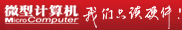

根据处理器核心数量、缓存大小等规格区别,E5 2600系列大致划分为三个档次——Advanced(高级)、Standard(标准)和Basic(基本)。基本版提供10MB三级缓存和6.4GT/s的QPI(快速互联通道),支持DDR3 1066;标准版提供15MB三级缓存和8.0GT/s的QPI,内存频率提高到DDR3 1333,增加了Turbo Boost 2.0第二代睿频加速技术(多可跳5级,500MHz)和超线程技术;高级版三级缓存提升到20MB,支持的内存频率进一步提高到DDR3 1600,Turbo Boost多可跳9级,单核心大加速900MHz。

此次发布的E5 2600系列处理器一共有17款,均为双路设计。相比上代至强X5000系列产品的Nehalem微架构,新的E5系列采用的内核是全新设计过的Sandy Bridge。该架构的高效能表现已经在至强E3产品上有所展现,而E5则是E3的扩展、增强版。

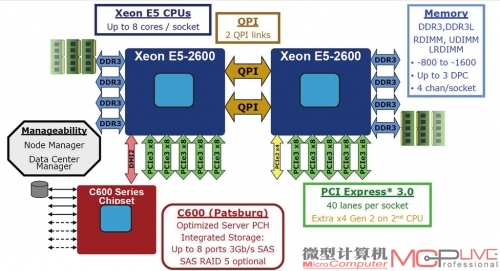

首先,相比至强X5000系列的交叉总线设计,至强E5引入了环形总线(Ring Bus)结构。E5产品的各个CPU核心、LLC缓存(L3缓存)及System Agent等部分都将由环形总线互连。在处理器不断通过扩展核心数量来获得性能提升的时代,多内核间相互交换数据若出现较大延迟反而会影响整体运算效率。相比传统的交叉总线设计,环形总线不仅能够让各个核心完美共享L3缓存,还能大幅减低设计复杂度,降低访问延迟,从而进一步提升整体运算速度。

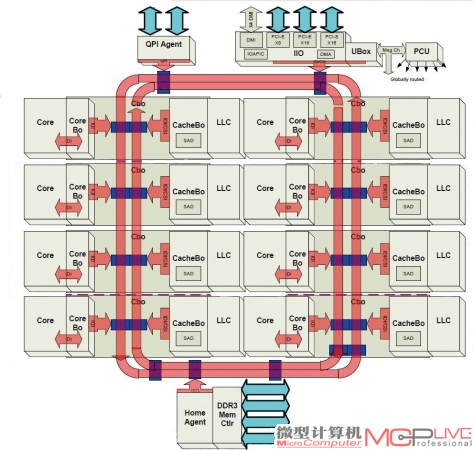

其次,它有一个名为Data Direct I/O的特色技术(以下简称为DDIO)。这项技术可以帮助处理器更快速、更智能地选择短路线来读写数据,从而提升I/O性能。通过右下图中进出两个方向的对比,我们能发现E5系统的数据读写已经不需要像以前那样经过内存才能完成。从LLC可以直接传输到核心中,这样就节省了繁琐的操作步骤,提供了更短的响应时间。之前需要4到5步的操作如今可以简化到3步完成,流水线少了一环,传输自然会更加快捷。

至强E5采用的双环形内部总线结构。该结构能让缓存的延迟明显降低,大约由原来的36~40个时钟周期减少到26~31个时钟周期。

解决了总线和缓存的效率问题,就能进一步支持指令效率的提高。随之而来的AVX即Advanced Vector Extensions高级矢量扩展入驻E5就显得顺理成章。AVX是继SSE4指令集后的新指令集,融合了乘法的双指令支持。从而可以更加容易地实现512位和1024位的扩展。E5允许256位AVX指令借用128位的整数SIMD数据路径,换句话说就是允许E5产品同时处理8个单精度浮点数和4个双精度浮点数,这让该系列产品在小的核心面积上实现了双倍于老产品的浮点吞吐量。

Data Direct I/O设计示意图。免去了数据在内存中转的步骤,让I/O效率更高。

理论上,以上设计能让E5处理器的内核效率提高到一个新的高度。但这还需要外部I/O效率的提升来配合,否则系统依旧会出现瓶颈。特别是对存储和I/O需求日益膨胀的云时代,外围数据吞吐量的需求更是日益增高。面对这样的情况,英特尔对互联总线规格和内存规格做出了大幅改进。

和上代至强X5000系列一样,至强E5产品也整合了DDR3内存控制器。不同的是,控制器规格由上代的3通道扩展到了4通道,频率也由DDR3 1066提升到了高DDR3 1600。由此E5的理论内存带宽达到了X5000系列的2倍。

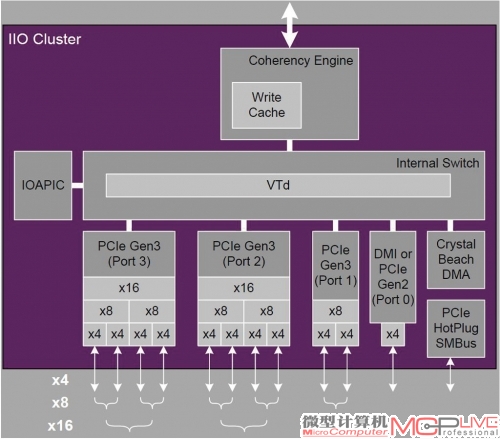

单路至强E5就能提供40条PCI-E 3.0总线。这40个PCI-E 3.0通道可以4条、8条或16条为单位自由组合成不同的端口。

此外,除了内存控制器,E5还将PCI-E控制器等更多原IOH的功能整合进了处理器。PCI-E规范也从Intel 5520 IOH的2.0版本提升到了3.0版本。每处理器支持高达40条直连的PCI-E 3.0通道,双路服务器多提供80条PCI-E 3.0通道,比两个Intel 5520 IOH提供的72条PCI-E 2.0通道数量还多。而且,相比PCI-E 2.0的5GT/s规格,PCI-E 3.0的传输速率提升到8GT/s。加之PCI-E 3.0规范使用了更为高效的编码方式,实际带宽接近倍增的效果。所以至强E5系统的实际总线传输能力相比至强X5000系统也几乎翻番。并且,因为PCI-E 3.0直连在处理器上,省去了QPI和IOH的中间传输环节,I/O通路缩短的效果是响应时间的下降,有利于改善整体传输的延迟。

既然I/O模块被整合进了处理器,那么处理器和芯片之间的连接就不再需要高速的QPI直连。所以新的E5系统改变了QPI总线的设计。处理器之间的QPI总线从原来的1条增加到2条,速率由之前的高6.4GT/s提升到了现在的8GT/s。由此,增强了多路服务器中各处理器间的通信能力。处理器与芯片组之间则不再使用QPI连接,而用相对低速的DMI总线替代。

说到芯片组,和E5处理器一同发布的C600芯片组也是Romley平台的重要组成部分,但它只是对至强E5 I/O能力的补充。主要是对USB、SAS和PCI-E 2.0等不需要太高传输速率的设备提供了相应的支持。有趣的是,我们不曾想到英特尔许诺的8端口SAS支持,提供的竟是3Gb/s的规范。其实早在去年宣布Romley平台将要整合8端口SAS支持能力的时候,6Gb/s就已经是SAS的主流规范了。可能是英特尔在开发SAS 6Gb/s控制器的过程中遇到了一些困难。

为了不影响至强E5平台上市的整体步伐,所以暂时选择了更为稳妥的3Gb/sSAS方案。当然仔细观看C600芯片的规格你会发现,8端口6Gb/s的SAS对C600来说也确实有些强人所难。C600与至强E5处理器间的连接已经不是高速的QPI总线了,而是DMI 2.0。其带宽相当于4倍速的PCI-E 2.0,单向为20Gb/s。而8端口的3Gb/s SAS的高带宽需求已达到24Gb/s,DMI 2.0已经无力应付。若将单个端口速度提升到6Gb/s SAS,即使把SAS端口数从8减至4个,DMI 2.0总线也无力承担高速传输的重任。

节能共内存一色,虚拟化与万兆齐飞

节能是大家都在谈论的话题,特别是数据中心的能耗需求是巨大的,因此企业用户对产品的能耗比更加关注。因此英特尔特地在至强E5系列中添加了动态开关技术(详见动态性能调整示意图)。

动态开关的动态性能调整示意。图中的3条线,绿色代表了佳性能、蓝色代表了均衡性能(提供动态开关),而黄色代表了均衡性能(不提供动态开关)。在开启动态开关之后,之前处于下风的均衡性能会有一个明显的提升,其吞吐量终能与佳性能重合。而能耗却能维持在均衡性能的水平,远低于佳性能状态。

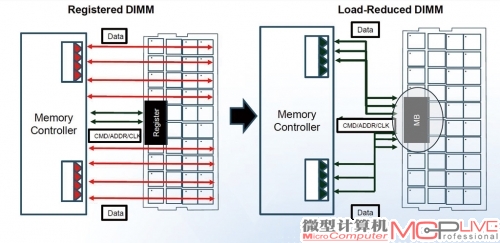

当然只有这个技术还远远不够,毕竟服务器动辄几百GB的内存规模早使内存模块成为了功耗大户。所以至强E5也加入了对LRDIMM(Load-Reduced DIMM,低负载DIMM)内存的支持。通过将RDIMM内存上的Register芯片改为iMB(isolation Memory Buffer)内存隔离缓冲芯片,LRDIMM内存降低了数据传输总线的负载,让内存系统的整体能耗下降到原来的50%。

LRDIMM内存工作原理,你能看到它和传统内存大不同是颗粒和内存控制器之间通过一颗缓冲芯片通信。

别以为LRDIMM只是为降低功耗而诞生的产物,它还是让至强E5系列内存支持能力比至强X5000翻番的大功臣。本来E5相对X5000的内存通道只多出一条,容量增幅约3 3 . 3%。归功于LRDIMM的缓冲存储机制,三星等厂商已经将单条内存的容量从16GB提升到32GB。因此双路E5产品能支持32GB×24=768GB的大容量内存,几乎是双路至强X5000系列的2.7倍。一台2U服务器要这么大的内存容量有什么用呢?很显然,这是为云时代更多的虚拟机要求而准备的大餐。相比双路至强X5000平台的多24线程的计算能力和多288GB(16GB×18)的内存容量,多达32线程的计算能力和高达768GB的内存容量,能让双路至强E5平台支持更多的虚拟机。

不过问题随之而来。服务器支持的虚拟机多了,对网络I/O的需求就会水涨船高。多虚拟机在高负载状态时,仅靠三、四个千兆以太网端口来传输数据,肯定会形成网络I/O瓶颈。增加更多的千兆网卡,一方面成本吃不消,另一方面线缆更加复杂,布线压力也随之增大。对此,英特尔为Romley平台配备了万兆以太网。通过主板的专用接口(PCI-E总线直连处理器)提供了英特尔82599万兆网络控制芯片,让系统获得了双端口的万兆网络支持。

“翻番”双路至强E5 2690 vs 双路至强X5680对比评测

看到此,大家对新平台的整体特性应该有个大致了解了。相比至强X5000,E5可谓从内到外焕然一新。理论上没有明显的数据传输瓶颈。那么它的实际性能表现如何呢?《微型计算机》有幸第一时间获得了英特尔送测的Server System R2000双路至强E5服务器,并联合至顶网和IT168进行了联合评测,希望为大家带来更详细、更专业的Romley平台信息。好了,现在就让我们来揭晓Romley平台的正真实力。

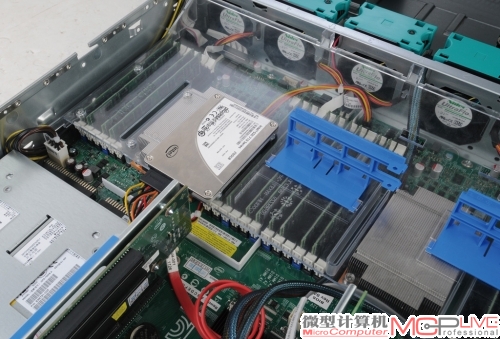

Server System R2000是一台2U服务器,前面有8个2.5英寸驱动器槽位。

服务器搭配了企业级的Intel 710 SSD作为系统盘,它被固定在导流罩上。

Server System R2000提供了24条内存接口。不过送测样机搭载的是16根8GB的DDR3 1600内存。

英特尔的万兆网络扩展卡,揭开散热片你就能看到Intel 82599万兆网络控制芯片。该子卡被反向安装在S2600GZ主板上,能提供两个万兆网络连接口。

| 新老两代至强处理器规格对比表 | ||

| 核心架构 | Sandy Bridge-EP | Westmere-EP |

| 核心工艺 | 32mn | 32mn |

| 核心/线程数量 | 8/16 | 6/12 |

| 主频 | 2.9GHz | 3.3GHz |

| 共享缓存大小 | 20MB | 12MB |

| 接口类型 | LGA 2011 | LGA 1366 |

| 指令集 | MMX,SSE,SSE2,SSE3,SSE4.1, SSE4.2,EM64T,VT-x,AES,AVX |

MMX,SSE,SSE2,SSE3,SSE4.1, SSE4.2,EM64T,VT-x,AES |

| Intel Server System R2000 | |

| 处理器 | 至强E5 2690×2 |

| 内存 | 三星DDR3 1600 8GB×16 |

| 主板 | Intel Server Board S2600GZ |

| 系统盘 | Intel 710SSD@6Gb/s |

实测一 计算性能突飞猛进

SiSoftware Sandra

SiSoftware Sandra是老牌的处理器性能测试软件,主要针对处理器的理论计算性能、内联核效率和内存性能进行测试。

至强E5 2690获胜是意料之中的事,E5 2690相比X5680具有压倒性的优势。计算性能,特别是浮点运算能力,E5 2690相对X5680几乎翻倍。内存带宽的提升也相当明显,带宽提升幅度超过了90%。此外,环形总线的应用,让E5 2690的共享缓存效率明显升高。内存和缓存总体带宽达到509.48GB/s,相比X5680系统的195.6GB/s提高了2.6倍!

SPEC CPU 2006

SPEC CPU 2006系统评估软件包括CINT2006和CFP2006两个子项目,分别用于测量整数性能和浮点性能。原本测试的结果包括base基准测试结果和peak峰值结果。但考虑到“Peak”允许在编译每一个Benchmark时进行专项专优化(也就是说Peak结果留给运行测试的厂商、评估者的优化余地较多,不同的优化会得到偏差较大的结果。),所以我们的测试仅以base测试的平均成绩作为参考。

| 至强E5 2690与至强X5680 SiSoftware Sandra计算性能对比测试成绩表 | ||

| SiSoftware Sandra | 双路Xeon E5 2690 | 双路Xeon X5680 |

| 处理器算术运算总本地功效 | 408.69GOPS | 249.2GOPS |

| 多媒体运算性能测试 | ||

| Multi-Media Int x16 iSSE4.1 | 746.66 MPixel/s | 534.13MPixel/s |

| Multi-Media Int x16 iSSE4.1/SPEED | 196.96 kPixel/s/MHz | 160.21kPixel/s/MHz |

| .NET多媒体性能测试 | ||

| 多媒体整数 x1 .NET | 126.14MPixel/s | 100.36MPixel/s |

| 多媒体整数x1 .NET/SPEED | 35.13kPixels/s/MHz | 30.10kPixels/s/MHz |

| 多媒体浮点数 x1 .NET | 51.47MPixel/s | 42.42MPixel/s |

| 多媒体浮点数 x1 .NET/SPEED | 14.33kPixels/s/MHz | 12.72kPixels/s/MHz |

| 多媒体双精度 x1 .NET | 103MPixel/s | 78.48MPixel/s |

| 多媒体双精度 x1 .NET/SPEED | 28.67 kPixels/s/MHz | 23.54kPixels/s/MHz |

| 缓存及内存测试 | ||

| 缓存/内存带宽 | 509.48 GB/s | 195.6GB/s |

| 缓存/内存带宽对比速度 | 137.62MB/s/MHz | 60.07MB/s/MHz |

| 速度因素(越小越好) | 30.9 | 35.2 |

| 内部数据高速缓存 | 1.51TB/s | 744.49GB/s |

| 二级板载高速缓存 | 1TB/s | 611GB/s |

| 三级板载高速缓存 | 517.84GB/s | 248.2GB/s |

至强E5 2690处理器整数(CINT2006)Benchmark总得分为606(多线程)/52(单线程),浮点(CFP2006)Benchmark总得分为487(多线程)/83.3(单线程)。对比双路至强X5680平台的测试结果可以看到,E5 2690在处理器的核心数仅提升33.33%的情况下(主频还更低),多线程整型基本调优(Base)成绩领先X5680超过54%。只看单线程整数运算E5 2690相比X5680也有15.56%的性能提升。

| 两代双路至强对比平台主要软、硬件信息一览 | ||

| 处理器 | 至强E5 2690×2 | 至强X5680×2 |

| 内存 | 128GB DDR3 1600(8GB×16) | 96GB DDR3 1600(8GB×12) |

| 硬盘 | Intel 710 SSD(200GB) | 146GB×4(RAID 0) |

| 操作系统 | RHEL 6.2 | RHEL 6.1 |

| 内核版本 | 2.6.32-220.e16.x86_64 | 2.6.32-131.0.15.e16.x86_64 |

| 文件系统 | Ext4 | Ext4 |

当然,比起整数运算来,支持AVX的E5 2690在浮点运算性能方面的提升更加明显。多线程浮点型Base测试中,E5 2690相比X5680的领先幅度则达到夸张的118.4%。即使只看单线程浮点性能,在主频明显劣势的情况下,E5 2690依然取得了领先X5680 41.4%的出色成绩。(两对比平台的详细软硬件信息、系统情况和测试成绩详见以上三个表格。子项成绩

均为多线程条件,成绩均记录base测试的平均值)

| 至强E5 2690与至强X5680 SPEC 2006整数性能对比测试成绩表 | |||

| 双路Xeon E5 2690 | 双路Xeon X5680 | ||

| 多线程整数基准测试Base | Copies | seconds | seconds |

| 400.perlbench | 32 | 454 | 319 |

| 401.bzip2 | 32 | 354 | 216 |

| 403.gcc | 32 | 367 | 228 |

| 429.mcf | 32 | 628 | 288 |

| 445.gobmk | 32 | 514 | 396 |

| 456.hmmer | 32 | 509 | 288 |

| 458.sjeng | 32 | 480 | 367 |

| 462.libquantum | 32 | 1490 | 828 |

| 464.h264ref | 32 | 808 | 502 |

| 471.omnetpp | 32 | 351 | 223 |

| 473.astar | 32 | 340 | 216 |

| 483.xalancbmk | 32 | 502 | 317 |

| 总分(多线程/单线程) | 606/52 | 392/45 | |

| 至强E5 2690与至强X5680 SPEC 2006浮点性能对比测试成绩表 | |||

| 双路Xeon E5 2690 | 双路Xeon X5680 | ||

| 多线程整数基准测试Base | Copies | seconds | seconds |

| 410.bwaves | 16 | 152 | 182 |

| 416.gamess | 32 | 551 | 336 |

| 433.milc | 32 | 114 | 161 |

| 434.zeusmp | 32 | 265 | 290 |

| 435.gromacs | 32 | 443 | 319 |

| 436.cactusADM | 32 | 303 | 293 |

| 437.leslie3d | 16 | 103 | 132 |

| 444.namd | 32 | 442 | 307 |

| 447.dealⅡ | 32 | 458 | 238 |

| 450.soplex | 16 | 114 | 154 |

| 453.povray | 32 | 686 | 437 |

| 454.calculix | 32 | 558 | 372 |

| 459.GemsFDTD | 16 | 98.8 | 130 |

| 465.tonto | 32 | 367 | 264 |

| 470.lbm | 32 | 95.1 | 134 |

| 481.wrf | 32 | 188 | 233 |

| 482.sphinx3 | 32 | 169 | 223 |

| 总分(多线程/单线程) | 606/52 | 392/45 | |

实测二 存储I/O喜忧参半

之前我们说到C600整合了8端口SAS 3Gb/s,这是英特尔的一次尝试。其实际效果如何呢?《微型计算机》评测室和ZDNet评测中心一起验证了英特尔在SAS上的实力。8个SAS 3Gb/s接口,理论上能提供约2GB/s的I/O速度。虽然搭配8个类似Intel 520这样的SSD肯定会遇到瓶颈。但若尽可能提高传输效率,让实际带宽逼近2GB/s。

板载的2个SAS 3Gb/s接口,皆为单接口4端口设计,共计8个SAS端口。

那么这个板载的SAS控制器还是能很好地满足HDD RAID的需求,为不需要高性能SSD RAID的Romley平台用户省下一笔存储卡扩展支出。作为对比,我们准备了提供8个SAS 6Gb/s 端口的LSI SAS 9211-8i HBA扩展卡。

8×SSD的待测存储系统。请注意,为了减少RAID层延时对大I/O性能的影响,我们并没有组建任何RAID,而是直接测试8×SSD情况时的系统吞吐能力。

要想榨取接口的性能极限,就需要足够高的数据传输率。我们准备了4×Intel 520加4×Intel 710共计8个SSD的配置。测试开始时,我们先在Intel C600芯片集成的3Gb/s SAS端口和LSI SAS 9211-8i HBA集成的6Gb/s SAS端口下,对单个Intel 710和Intel 520的持续读取能力进行了测试,并据此估算出8个SSD并发读取时的理论值。限于DMI 2.0总线实际传输速度只有4×PCI-E 2.0,约1.8GB/s。因此,我们8×SSD组合2.02GB/s的理论速率是完全能喂饱这个板载SAS的。

主板上的专用I/O接口,用来连接Intel RMS25CB080模块。其核心是一颗LSI SAS2208芯片。它是早支持PCI-E 3.0标准的6Gb/s SAS控制器,SAS端口数量也是8个。

终测试结果让我们颇感意外,原本我们以为C600集成的8×3Gb/s SAS能获得接近1.8GB/s的传输性能,实际上限却仅能到达900MB/s。这样的数据传输性能可能连高性能的8×HDD都满足不了。而LSI SAS 9211-8i HBA的表现则相当优秀。基本上和理论I/O值相吻合,高速率达到了2.8GB/s。

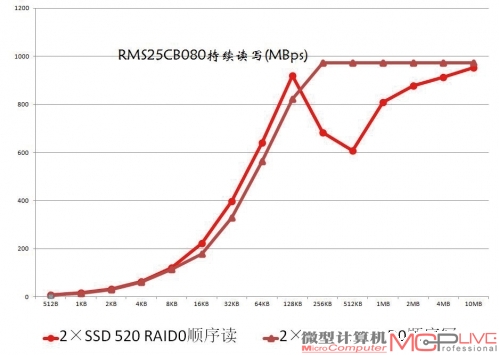

RMS25CB080模块下,2×Intel 520 SSD RAID 0测试成绩。

可能正是考虑到C600集成的SAS性能水平有限,英特尔为送测的Server System R2000系统搭配了一款型号为Intel RMS25CB080的集成RAID模块。这个模块理论上能为我们带来8GB/s的大I/O性能,鉴于我们还没有能对它造成压力的I/O系统。所以我们只简单测试了用它组建两块Intel 520 SSD RAID 0的效率。测试结果相当满意,这个RAID的性能基本上接近了单个Intel 520性能的两倍。

| Intel 520/710SSD数据传输能力实测数据表 | ||

| 顺序读(MB/s) | C600 3Gb/s SAS | 6Gb/s SAS HBA |

| SSD 710 | 253 | 266 |

| SSD 520 | 252 | 514 |

| 4×(710+520) | 2020 | 3120 |

实测三 网络I/O提升10倍

在这里不得不说一下,送测的平台并没有随机配备SFP+光纤模块,所以用户不论以什么途径提供光纤模块都将增加每端口成本,算下来将是笔不小的开支。针对此,我们认为:要想让万兆网络迅速普及开来,先得让相对廉价且易用的10GBase-T Cat-6/6a标准成为市场主流。

想在评测室中体验万兆网络并不容易,为此我们设计了2台Server System R2000服务器互联,通过虚拟机迁移来体验网络性能的测试方案。并分别对比了两服务器间用万兆端口和双千兆端口迁移的性能。我们创建了分配有64GB内存的虚拟机蓝本,并克隆了8个。将它们全部放在一台Server System R2000服务器上,全部开机。由于测试平台内存总容量的限制,每个虚拟机实际占用的内存约为12GB。随后,我们以1、4、8为单位向另一台Server System R2000服务器上迁移。来回各一次,记录迁移时间。

红色方框内显示了万兆网络(vmnic4,1.2GB/s)与千兆网络(vmnic2,接近120MB/s)峰值速率的对比,正好是10倍的差距。两个红色椭圆框的对比则更直观,左侧是千兆网络迁移的状况,可以看到分两批迁移(每批4个VM),中间的停顿比较长;右侧的万兆网络迁移时间(横轴)短很多,纵轴(传输率)则相当高。

对比的结果比较有趣。在同时迁移的虚拟机数量较少的时候(1个和4个),双千兆网络所用的时间不到万兆网络的5倍。由此看,万兆网络的效率貌似不高。其实这只是因为迁移开始前,系统需要进行一些预处理(在本地做一些运算和处理)。这段时间vMotion网络上流量甚少,万兆网络和千兆网络没有什么区别,消耗的时间差不多,随后迁移才正式开始。由于之前用掉了一些时间做预处理,所以万兆网络5倍的带宽优势就被抵消了一些。

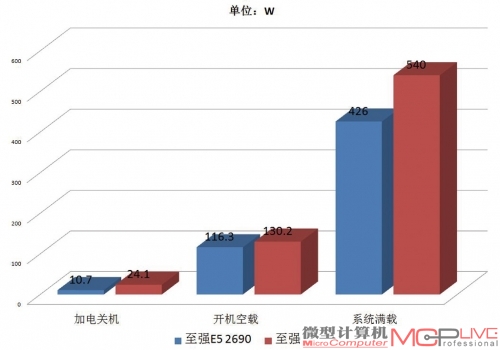

双路至强E5 2690、X5680功耗对比。新系统优秀的性能并没有以增加功耗为前提,相反的,至强E5 2690系统的功耗表现还全面优于老系统。

但当同时迁移的虚拟机数量提升到8个时,双千兆网络所用的时间又超过了万兆网络的5倍,甚至接近6倍。这又是为什么呢?仔细观察迁移曲线图(左上),你会发现:在双千兆网络上,由于高带宽的限制,vMotion没有同时启动8个虚拟机的迁移,而是分成两批。每次预处理的只有4个虚拟机信息。在第一批迁移接近完成,第二批迁移将要启动的时候,“交接”的时间相对较长,导致总用时比依旧一次预处理8个交换机信息的万兆网络要长得多。

| 万兆和双千兆网络迁移虚拟机耗时对比表 | ||

| vMotion数量 | 2×1Gb网络耗时 | 10Gb网络耗时 |

| 1 | 129s | 30s |

| 4 | 460s | 111s |

| 8 | 1449s | 246s |

当然,面对并不成熟的万兆网络应用环境,我们的体验和测试只能算是浅尝辄止。但这也足够展示出万兆网络相比当前千兆网络的性能优势。后续我们将为大家带来更多的万兆网应用指南和性能测试,用户们尽情期待吧。

Romley——没有瓶颈的云端立交,只欠互联高速

Romley平台不论是计算性能还是I/O性能上的表现都极为出色,相比上代产品甚至有翻番的提升。特别是万兆网络的一次载入优势和高持续传输能力,让人映像深刻。如果说未来的云计算环境就是一个错综复杂的数据交通网络,那么大大小小的服务器就是一个个重要的云端立交。现在,Romley平台已经将更先进的立交架构带到我们面前,也带来了新的万兆高速连接方案。剩下的就是等待10GBaet-T的快速普及,并期待未来更加顺畅和精彩的云应用!

LRDIMM内存的引入,让E5 2600系列能提供了至强X5600系列2.6倍的内存支持能力。新平台对虚拟化市场的促进无疑会相当明显。

从对比上我们可以看出,至强E5 2690相比上一代的X5680来说各方面都进步明显。更快速的相应时间、更强大的性能和更低的功耗是我们希望看到的,而英特尔的确给了我们这些新的惊喜。

MC点评:在我们的测试中,以至强E5处理器为核心的Romley平台表现相当出色。相比至强X5500系列,它在计算性能、I/O、内存性能、存储性能和功耗控制等各方面都体现出了“换代”的绝对优势。事实上,凭借在网络和存储上的技术创新,Romley平台无疑会成为云计算时代企业用户的绝佳选择,担负起英特尔期望中的“未来服务器平台中流砥柱”的使命应该不成问题。